- Details

- Category: การศึกษา

- Published: Monday, 28 November 2022 17:35

- Hits: 1917

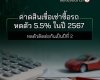

วิศวะมหิดล - JAIST เตือนภัย...เผยผลวิจัย AI - Machine Learning ถูกโจมตีผ่านข้อมูลซ่อนในคิวอาร์โค้ดได้ ชี้ 2 แนวทางป้องกัน

โลกแห่งศตวรรษที่ 21 นั้น เทคโนโลยีปัญญาประดิษฐ์ (AI) และ Machine Learning (ML) ได้รับความนิยมเป็นซูเปอร์ฮิตดังแก้วสารพัดนึก แต่ยังมีคำถามว่าปลอดภัยไว้วางใจได้ 100% หรือไม่ ? ทีมวิศวกรนักวิจัยไทย-ญี่ปุ่น โดย คณะวิศวกรรมศาสตร์ มหาวิทยาลัยมหิดล ร่วมกับ สถาบันวิทยาศาสตร์และเทคโนโลยีขั้นสูงแห่งประเทศญี่ปุ่น หรือ JAIST (Japan Advanced Institute of Science and Technology) เปิดผลวิจัยสุดเซอร์ไพรส์โดยได้รับการตีพิมพ์ในวารสารนานาชาติ เรื่อง ‘การโจมตีการเรียนรู้ของเครื่องผ่านรูปแบบตัวอย่างปฏิปักษ์ (Attacking Machine Learning With Adversarial Examples)’ ชี้ให้เห็นว่า Machine Learning ยังมีช่องโหว่ภัยความเสี่ยงจากการโดนโจมตีที่จะสร้างความเสียหายได้ ตอกย้ำว่าแม้เทคโนโลยีจะเลิศล้ำเพียงใด ยังจำเป็นต้องมีมนุษย์ตรวจสอบเพื่อยืนยันผลลัพธ์ที่เชื่อถือได้

ผศ. ปริญญา ศิริธนวันต์ (JAIST), ดร. กรินทร์ สุมังคะโยธิน (วิศวะมหิดล), ศ. โคตานิ คาซุโนริ (JAIST)

รศ.ดร.จักรกฤษณ์ ศุทธากรณ์ คณบดีคณะวิศวกรรมศาสตร์ มหาวิทยาลัยมหิดล กล่าวว่า ปัจจุบันเทคโนโลยี AI และ Machine Learning (ML) มีบทบาทในวิถีชีวิตของประชาชน การทำงาน และหลายธุรกิจอุตสาหกรรม เช่น การแพทย์สุขภาพ ธุรกิจการค้า อีคอมเมิร์ซ ตลาดทุนการเงิน ยานยนต์ขนส่งโลจิสติกส์ โทรคมนาคม การผลิตในอุตสาหกรรม ความมั่นคงปลอดภัยจึงเป็นเรื่องสำคัญ ผลงานวิจัย ‘การโจมตีการเรียนรู้ของเครื่องผ่านรูปแบบตัวอย่างปฏิปักษ์’ นี้ได้รับการตีพิมพ์ใน ‘วารสารนานาชาติ Journal of Imaging’ ได้รับความสนใจอย่างสูงจากประชาคมโลก เนื่องจากเป็นครั้งแรกที่มีการออกแบบการโจมตี ML Model ในรูปแบบของ QR Code ซึ่งจะเป็นประโยชน์ต่อความมั่นคงปลอดภัยของบริการที่เข้าถึงประชาชนและองค์กรในวงการต่างๆ สำหรับทีมนักวิจัยไทย-ญี่ปุ่น 3 คน มาจากการผนึกความร่วมมือระหว่างคณะวิศวกรรมศาสตร์ มหาวิทยาลัยมหิดล และสถาบันวิทยาศาสตร์และเทคโนโลยีขั้นสูงแห่งประเทศญี่ปุ่น (JAIST) ประกอบด้วย ดร. กรินทร์ สุมังคะโยธิน อาจารย์ภาควิชาวิศวกรรมคอมพิวเตอร์ คณะวิศวะมหิดล ศ. โคตานิ คาซุโนริ และ ผศ. ปริญญา ศิริธนวันต์ จากสถาบัน JAIST

ดร. กรินทร์ สุมังคะโยธิน อาจารย์ภาควิชาวิศวกรรมคอมพิวเตอร์ คณะวิศวกรรมศาสตร์ มหาวิทยาลัยมหิดล กล่าวถึงที่มาของงานวิจัย ว่า AI ปัญญาประดิษฐ์เป็นการทำให้คอมพิวเตอร์หรือเครื่องจักรฉลาด ส่วนMachine Learning (ML) เป็นหนึ่งในกระบวนการเรียนรู้ของ AI โดยการนำเข้าข้อมูลสู่อัลกอริทึม เพื่อสร้างโครงข่ายการตัดสินใจในการคาดคะเนแนวโน้มหรือทำนายผลลัพธ์ คล้ายคลึงกับการตัดสินใจของมนุษย์ เพื่อลดภาระงานหนักและความผิดพลาดจากความเหนื่อยล้า ตัดสินใจได้รวดเร็วกว่าเมื่อเทียบกับการทำงานของมนุษย์ อย่างไรก็ตามความเข้าใจถึงโครงสร้างการตัดสินใจของเน็ตเวิร์คโมเดลของ Machine Learning นั้นยังคงคลุมเครือ ทำให้ในปัจจุบัน Machine Learning สามารถถูกโจมตีผ่านความคลุมเครือดังกล่าวจากผู้ประสงค์ร้าย เพื่อใช้ประโยชน์จากผลลัพธ์ที่ผิดเพี้ยน ด้วยเหตุนี้ทีมนักวิจัยจึงทำการศึกษาวิจัยด้านการโจมตี ML โดยมี วัตถุประสงค์เพื่อศึกษารูปแบบการโจมตีโดยมุ่งเน้นการโจมตีที่สามารถหลบหลีกการสังเกตุจากมนุษย์ ซึ่งอาจจะสร้างความเสียหายหรือผลเสียได้อย่างมหาศาล ไม่ว่าจะเป็นแวดวงการเงิน การรักษาพยาบาล การสื่อสาร คมนาคมขนส่ง ระบบรักษาความปลอดภัยของข้อมูล ระบบการผลิต จนถึงระบบการป้องกันประเทศ

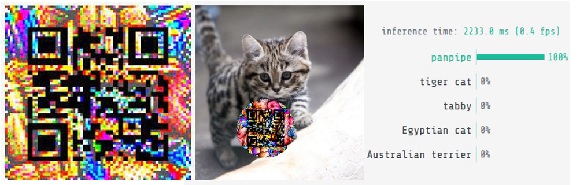

ทีมวิจัยวิศวะมหิดล - JAIST ใช้เวลาศึกษาวิจัยร่วมกันกว่า 3 ปี แม้จะมีอุปสรรคช่วงวิกฤติโควิด-19 แต่ก็สามารถทำงานผ่านระบบออนไลน์บนแพลตฟอร์มที่มีประสิทธิภาพระดับสูงของญี่ปุ่น เราได้ศึกษาวิเคราะห์และออกแบบ การโจมตีการเรียนรู้ของ ML ผ่านรูปแบบตัวอย่างปฏิปักษ์ บนสมมุติฐานโดยที่มีเป้าหมายในการโจมตี ML Model และสามารถหลบเลี่ยงการสังเกตจากมนุษย์ ทำให้ส่งผลกระทบต่อการตัดสินใจผิดพลาดของเครื่องจักร โดยการโจมตีนั้นสามารถมุ่งเป้าไปที่ผลลัพธ์ใดๆ ที่ถูกกำหนดไว้ล่วงหน้าได้ โดยเราได้กำหนดรูปแบบการโจมตีผ่านข้อมูลที่ถูกซ่อนใน ‘รูปแบบ QR-Code’ สำหรับฟังก์ชั่นการทำงาน ของการโจมตีในรูปแบบ Adversarial Examples เป็นการหลอก AI ให้สับสน โดยการใส่ข้อมูลปนเปื้อนลงไปในข้อมูลเป้าหมาย อาทิ ข้อมูลภาพ, ข้อมูลเสียง, ข้อมูลสัญญาณ หรือ ข้อมูลประเภทอื่นๆ โดยผลการโจมตีนั้นมีทั้งแบบการกำหนดผลลัพธ์จากการโจมตีไว้ล่วงหน้า หรือ ทำให้ผลลัพธ์คลาดเคลื่อนจากสิ่งที่ควรจะเป็นได้

สรุปผลการวิจัย สามารถบีบอัดให้ข้อมูลการโจมตีผ่านข้อมูลที่ถูกซ่อนใน QR-Code ที่สามารถแสกนได้ และยังคงความสามารถของการโจมตีแบบมุ่งเป้าหมายผลลัพธ์ได้เป็นอย่างดี นอกจากการใช้ในการทดสอบการโจมตี Machine Learning แล้ว งานวิจัยชิ้นนี้ยังสามารถนำมาใช้พัฒนา ระบบป้องกันและตรวจจับการโจมตีจากการวิเคราะห์โดย ML Model ในหลายๆ วัตถุประสงค์อีกด้วย เช่น ปกป้องความเป็นส่วนตัว ระบบป้องกันทางการทหาร อีกด้วย เป็นการพิสูจน์ให้เห็นว่าการตัดสินใจของ Machine Learning ควรใช้เป็นเพียงเครื่องมือและนวัตกรรมที่ช่วยลดภาระงานของมนุษย์เท่านั้น ท้ายสุดแล้วยังคงต้องได้รับการตรวจสอบจากมนุษย์ผู้เชี่ยวชาญเพื่อยืนยันผลลัพธ์เป็นขั้นตอนสุดท้าย

จากความสำเร็จของงานวิจัยชิ้นนี้ แผนในอนาคต ทีมวิจัยไทย-ญี่ปุ่น จะคิดค้นหาวิธีการที่สามารถโจมตีได้มีประสิทธิภาพในระดับสูงยิ่งขึ้นอีก เพื่อก้าวทันเทคโนโลยีใหม่ๆ ที่เปลี่ยนแปลงรวดเร็ว และยังคงไว้ซึ่งความสามารถในการทำงานของรูปแบบข้อมูลดั้งเดิม (เช่น การโจมตีในรูปแบบ QR-Code ต้อง Scan ได้ เป็นต้น)

สำหรับวิธีป้องกันการโจมตี Adversarial Example Attackในอนาคต มี 2 แนวทาง ได้แก่ 1.ใช้การโจมตี Adversarial Example เพื่อปกป้องข้อมูลจากการถูกตรวจสอบที่ไม่ได้รับอนุญาต 2. ใช้ข้อมูลที่ได้จากการโจมตี Adversarial Example นำกลับมาเพื่อวิเคราะห์ถึงการโจมตี และออกแบบ Machine Learning โมเดลที่ทนทานต่อการโจมตีมากยิ่งขึ้น

ข้อแนะนำในการใช้ Machine Learning อย่างปลอดภัย พึงระวังเสมอว่า ข้อมูลนำเข้าอาจถูกปนเปื้อนการโจมตีมุ่งเป้าในรูปแบบต่างๆ เช่น Adversarial Example หรืออาจพ่วงมากับมัลแวร์ ดังนั้นการใช้ Machine Learning เพื่อการทำงานที่มั่นคงและปลอดภัย มีความจำเป็นต้องมีวาง ระบบการตรวจสอบผลลัพธ์สุดท้ายโดยผู้เชี่ยวชาญ เพื่อความถูกต้องที่เชื่อถือได้อีกครั้ง อย่าปล่อยให้ Machine ทำงาน 100% ในปัจจุบัน AI และ Machine Learning ยังมีข้อจำกัดและจะเป็นตัวช่วยที่ดีได้ก็ต่อเมื่อทั้งคนและเครื่องจักรมีการคิดและทำงานประสานกันอย่างสมดุล ไม่อ้างอิงฝ่ายใดฝ่ายหนึ่งมากจนเกินไป

A111073